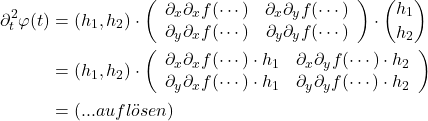

Ein Gradient ist so etwas wie die Ableitung einer Funktion aus dem ![]() . Vom Gedanken her läuft man bei dieser Art der Ableitung die Funktion einmal in x-Richtung und einmal in y-Richtung ab. Vieles davon ist im Grunde Matrix-Multiplikation, daher der Vektor mit den beiden Ableitungen. Als Erinnerung, die Ableitung funktioniert quasi nach der Kettenregel

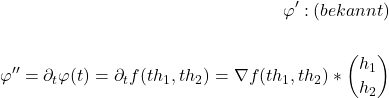

. Vom Gedanken her läuft man bei dieser Art der Ableitung die Funktion einmal in x-Richtung und einmal in y-Richtung ab. Vieles davon ist im Grunde Matrix-Multiplikation, daher der Vektor mit den beiden Ableitungen. Als Erinnerung, die Ableitung funktioniert quasi nach der Kettenregel ![]() . Das * bezeichnet das \textit{Skalarprodukt}.

. Das * bezeichnet das \textit{Skalarprodukt}.

\section*{Analyse von ![]() auf Geraden

auf Geraden ![]() }

}

![]()

Wir betrachten ab jetzt die Ableitung \textit{entlang von Kurven}. Diese Kurven sind praktischerweise Geraden und wir bezeichnen sie mit ![]() . Wobei

. Wobei ![]() , beliebig, aber fest.

, beliebig, aber fest.

![]()

Es ist quasi der Versuch, die Umgebung von ![]() zu untersuchen. Wir kennen aus 1D (Taylor).

zu untersuchen. Wir kennen aus 1D (Taylor).

![]()

\section*{Taylor-Entwicklung in 2D}

Wie wir später sehen werden ist die 1D-Taylor-Entwicklung lediglich ein spezialfall der allgemeineren Form. Da die Herleitung allerdings in über Funktionen ![]() geschehen ist, ist das nicht aufgefallen. Wir verallgemeinern nun.

geschehen ist, ist das nicht aufgefallen. Wir verallgemeinern nun.

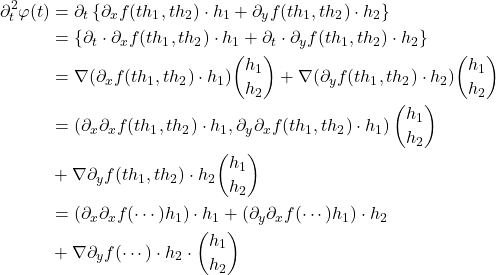

Wir bilden nun die zweite Ableitung in höheren Dimensionen. Anstelle einer einzelnen Zeile (wie etwa in 1D) erhalten wir eine Matrix mit den jeweiligen partiellen Ableitungen.

Wir sammeln dann alle Terme ein und schreiben die Gradienten als Matrix: